Эксперимент с компьютерным зрением: кого видит камера у подъезда

Каждый день мимо двери моего подъезда проходят десятки людей. Иногда это знакомые соседи, но чаще - курьеры или случайные гости.

Домофонная камера всё записывает, но вручную пересматривать часы видео бессмысленно. Мне стало интересно: можно ли разово прогнать архив записей через алгоритмы компьютерного зрения и посмотреть, как быстро GPU справится с такой задачей.

Это был чисто экспериментальный проект: не «система слежки», а тест производительности и возможностей CUDA в связке с dlib и face_recognition.

На словах всё выглядело просто, а на деле пришлось пройти целый квест из несовместимых программ, капризных драйверов и упрямой библиотеки распознавания лиц. Но в итоге я собрал рабочее окружение и хочу поделиться опытом - возможно, это поможет тем, кто столкнётся с похожими проблемами.

Проект выложен на GitHub.

Часть 1: Битва за dlib с CUDA-ускорением на Ubuntu

dlib - это популярная библиотека на Python для компьютерного зрения и машинного обучения, особенно известная своим модулем распознавания лиц. Она умеет искать и сравнивать лица. Однако «из коробки» через pip она работает только на CPU, что для задач с большим объёмом данных ужасно медленно.

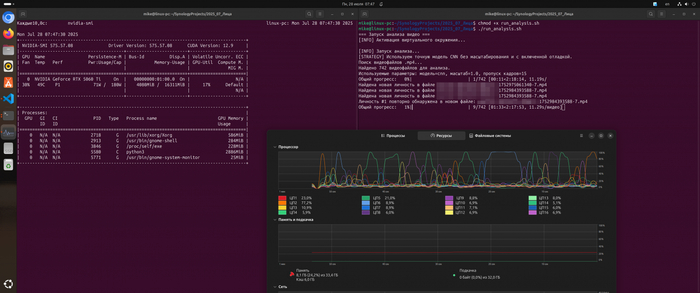

У меня видеокарта NVIDIA GeForce RTX 5060 Ti 16 ГБ и здесь на помощь приходит CUDA-ускорение - технология NVIDIA, позволяющая выполнять вычисления на графическом процессоре видеокарты. Для распознавания лиц это критично: обработка видео с несколькими тысячами кадров на CPU может занять часы, тогда как с GPU - минуты. CUDA задействует сотни параллельных потоков, что особенно эффективно для матричных операций и свёрточных сетей, лежащих в основе face_recognition.

Именно поэтому моя цель была не просто «запустить dlib», а сделать это с полной поддержкой GPU.

Эта часть рассказывает о том, как простая, на первый взгляд, задача превратилась в двухдневную борьбу с зависимостями, компиляторами и версиями ПО.

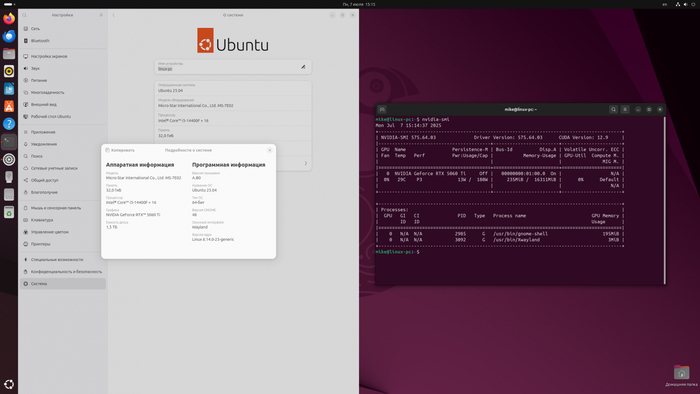

Неподходящая Ubuntu 25.04, моя конфигурация полностью описана здесь

Расписываю по шагам - может быть кто-то найдёт эту статью через поиск и ему пригодится.

1. Исходная точка и первая проблема: неподходящая версия Python

Задача: установить face_recognition и его зависимость dlib на свежую Ubuntu 25.04.

Предпринятый шаг: попытка установки в системный Python 3.13.

Результат: ошибка импорта face_recognition_models. Стало ясно, что самые свежие версии Python часто несовместимы с библиотеками для Data Science, которые обновляются медленнее.

Решение: переход на pyenv для установки более стабильной и проверенной версии Python 3.11.9. Это был первый правильный шаг, решивший проблему с совместимостью на уровне Python.

2. Вторая проблема: dlib работает, но только на CPU

Предпринятый шаг: после настройки pyenv и установки зависимостей (numpy, opencv-python и т.д.), dlib и face_recognition успешно установились через pip.

Результат: скрипт анализа видео работал ужасно медленно (несколько минут на одно видео). Мониторинг через nvidia-smi показал 0% загрузки GPU.

Диагноз: стандартная установка dlib через pip скачивает готовый бинарный пакет ("wheel"), который собран без поддержки CUDA для максимальной совместимости. Чтобы задействовать GPU, dlib нужно компилировать из исходного кода прямо на моей машине.

3. Третья, главная проблема: конфликт компиляторов CUDA и GCC

Предпринятый шаг: попытка скомпилировать dlib из исходников с флагом -DDLIB_USE_CUDA=1.

Результат: сборка провалилась с ошибкой. Анализ логов показал, что cmake находит CUDA Toolkit 12.6, но не может скомпилировать тестовый CUDA-проект. Ключевая ошибка: error: exception specification is incompatible with that of previous function "cospi"

Диагноз: мой системный компилятор GCC 13.3.0 (стандартный для Ubuntu 25.04) был несовместим с CUDA Toolkit 12.6. Новые версии GCC вносят изменения, которые ломают сборку с более старыми версиями CUDA.

4. Попытки решения конфликта компиляторов

Шаг №1: установка совместимого компилятора. Я установил gcc-12 и g++-12, которые гарантированно работают с CUDA 12.x.

Шаг №2: ручная сборка с указанием компилятора. Я пытался собрать dlib вручную, явно указав cmake использовать gcc-12:

cmake .. -DCMAKE_C_COMPILER=gcc-12 -DCMAKE_CXX_COMPILER=g++-12 ...

Результат: та же ошибка компиляции. cmake, несмотря на флаги, по какой-то причине продолжал использовать системные заголовочные файлы, конфликтующие с CUDA.

Шаг №3: продвинутый обходной маневр (wrapper). Я создал специальный скрипт-обертку nvcc_wrapper.sh, который должен был принудительно "подсовывать" nvcc (компилятору NVIDIA) нужные флаги и использовать gcc-12.

Результат: снова неудача. Ошибка 4 errors detected in the compilation... осталась, что указывало на фундаментальную несовместимость окружения.

Капитуляция перед реальностью

Несмотря на все предпринятые шаги - использование pyenv, установку совместимого компилятора GCC-12 и даже создание wrapper-скриптов - dlib так и не удалось скомпилировать с поддержкой CUDA на Ubuntu 25.04.

Похоже проблема была не в моих действиях, а в самой операционной системе. Использование не-LTS релиза Ubuntu для серьезной разработки с проприетарными драйверами и библиотеками (как CUDA) - это путь, полный боли и страданий.

Принял решение установить Ubuntu 24.04 LTS, для которой NVIDIA предоставляет официальную поддержку CUDA Toolkit 12.9 Update 1.

Часть 2: чистый лист и работающий рецепт

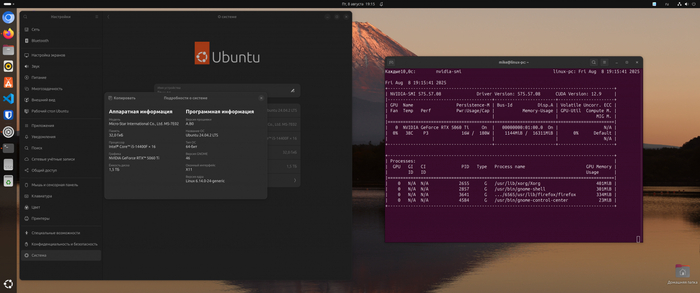

Установил Ubuntu 24.04 LTS - систему с долгосрочной поддержкой, для которой NVIDIA предоставляет официальный CUDA Toolkit и драйверы. Это был шаг назад, чтобы сделать два вперёд.

Но даже на чистой системе путь не был устлан розами. Первые попытки установки нужной версии Python через apt провалились (в репозиториях Noble Numbat её просто не оказалось), что вернуло меня к использованию pyenv. После нескольких итераций, проб и ошибок, включая установку CUDA Toolkit и отдельно cuDNN (библиотеки для нейросетей, без которой dlib не видит CUDA), родился финальный, работающий рецепт.

"Золотой" скрипт установки

Вместо того чтобы описывать десятки команд, которые я вводил вручную - собрал все шаги в единый установочный скрипт setup_env.sh. Что он делает:

Проверка pyenv. Скрипт начинается с проверки наличия pyenv. Это позволяет использовать нужную версию Python (3.11.9), а не системную, избегая конфликтов.

Установка системных библиотек. Для компиляции dlib из исходного кода необходимы инструменты сборки (build-essential, cmake) и библиотеки для работы с математикой и изображениями (libopenblas-dev, libjpeg-dev). Скрипт автоматически их устанавливает.

Важно: скрипт предполагает, что CUDA Toolkit и отдельно cuDNN уже установлены по официальным инструкциям NVIDIA для вашей системы - они по ссылкам.

Создание чистого venv. Создаем изолированное виртуальное окружение, чтобы зависимости нашего проекта не конфликтовали с системными. Скрипт удаляет старое окружение, если оно существует, для гарантированно чистой установки.

Ключевой момент: установка dlib. Это сердце всего процесса. Команда pip install dlib с особыми флагами:

--no-binary :all: — этот флаг принудительно запрещает pip скачивать готовый, заранее скомпилированный пакет (wheel). Он заставляет pip скачать исходный код dlib и начать компиляцию прямо на вашей машине.

--config-settings="cmake.args=-DDLIB_USE_CUDA=1" — а это инструкция для компилятора cmake. Мы передаем ему флаг, который говорит: «При сборке, пожалуйста, включи поддержку CUDA».

Именно эта комбинация заставляет dlib собраться с поддержкой GPU на Ubuntu 24.04 LTS чтобы использовать видеокарту, а не в стандартном CPU-only варианте.

Вот сам скрипт setup_env.sh:

#!/bin/bash

set -e

VENV_DIR=".venv"

PYTHON_VERSION_TARGET="3.11.9"

echo "=== Установка окружения и зависимостей ==="

# --- Проверка наличия pyenv ---

if ! command -v pyenv &> /dev/null; then

echo -e "\n\033[1;31m[ERROR] pyenv не найден. Установи pyenv перед запуском.\033[0m"

exit 1

fi

echo -e "\n[INFO] Выбор версии Python $PYTHON_VERSION_TARGET через pyenv..."

pyenv local $PYTHON_VERSION_TARGET

echo "[INFO] Текущая версия Python: $(python --version)"

# --- Проверка системных библиотек ---

echo -e "\n[INFO] Проверка и установка системных библиотек для dlib..."

sudo apt update

sudo apt install -y build-essential cmake libopenblas-dev liblapack-dev libjpeg-dev git

# --- Очистка и создание виртуального окружения ---

if [ -d "$VENV_DIR" ]; then

echo "[INFO] Удаление старого виртуального окружения '$VENV_DIR'..."

rm -rf "$VENV_DIR"

fi

echo "[INFO] Создание виртуального окружения '$VENV_DIR'..."

python -m venv "$VENV_DIR"

echo "[INFO] Активация окружения..."

source "$VENV_DIR/bin/activate"

echo "[INFO] Установка Python-зависимостей..."

pip install --upgrade pip

pip install -r requirements.txt

echo "[INFO] Установка dlib с поддержкой CUDA..."

pip install dlib \

--no-binary :all: \

--verbose \

--config-settings="cmake.args=-DDLIB_USE_CUDA=1"

echo "[INFO] Установка face_recognition..."

pip install face_recognition

echo -e "\n\033[1;32m[OK] Окружение и зависимости успешно установлены.\033[0m"

requirements.txt:

numpy opencv-python git+https://github.com/ageitgey/face_recognition_models tqdm

Часть 3: собираем все вместе

После победы над зависимостями у меня есть полностью рабочее окружение с CUDA-ускорением. Настало время применить его к реальным данным. Мои исходные данные - это архив видеозаписей с двух IP-камер, которые пишут видео на сетевой накопитель Synology Surveillance Station (есть аналоги). Для приватности я заменю реальные имена камер на условные:

podiezd_obshiy\ - камера, смотрящая на лифтовой холл.

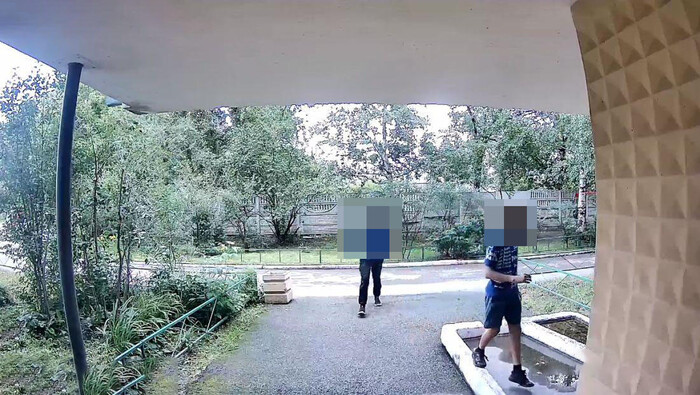

dver_v_podiezd\ - камера из домофона, направленная на улицу.

Внутри каждой папки видео отсортированы по каталогам с датами в формате ГГГГММДД с суффиксом AM или PM. Сами файлы имеют информативные имена, из которых легко извлечь дату и время записи: podiezd_obshiy-20250817-160150-....mp4.

Камера из домофона, направленная на улицу. Здесь качество гораздо лучше потому что камера цифровая, а не аналоговая как у меня из квартирного домофона. Это фото из интернета

С данными разобрались, теперь перейдем к инструменту - Python-скрипту face_report.py. Скрипт служит разовым инструментом анализа архива видео, чтобы протестировать работу CUDA.

Общая архитектура скрипта

Я использовал стандартную библиотеку argparse. Она позволяет задавать ключевые параметры прямо из командной строки:

--model: выбор детектора лиц (hog или cnn).

--scale: коэффициент масштабирования кадра. Уменьшение кадра (например, до 0.5) ускоряет обработку, но может пропустить мелкие лица.

--skip-frames: количество пропускаемых кадров. Анализировать каждый кадр избыточно и медленно; достаточно проверять каждый 15-й или 25-й.

Скрипт находит все .mp4 файлы в указанной директории и запускает основной цикл, обрабатывая каждый видеофайл.

1. Детекция лиц: HOG против CNN

face_recognition предлагает два алгоритма детекции: HOG (Histogram of Oriented Gradients) и CNN (Convolutional Neural Network). HOG - классический и очень быстрый метод, отлично работающий на CPU. CNN - это современная нейросетевая модель, гораздо более точная (особенно для лиц в профиль или под углом), но крайне требовательная к ресурсам.

Раз я так боролся за CUDA, выбор очевиден - будем использовать cnn. Это позволит находить лица максимально качественно, не жертвуя скоростью.

2. Уникализация личностей

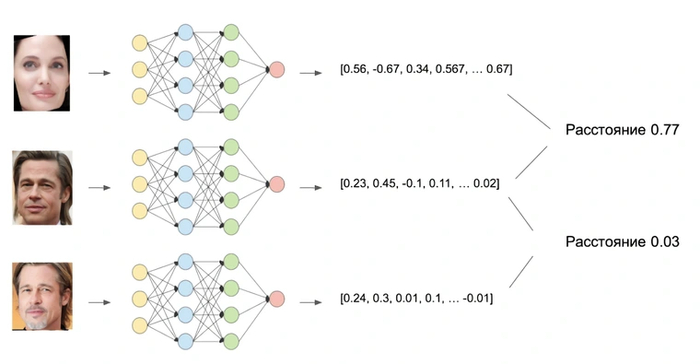

Как скрипт понимает, что лицо на двух разных видео принадлежит одному и тому же человеку? Он преобразует каждое найденное лицо в face_encoding - вектор из 128 чисел, своего рода уникальный «цифровой отпечаток».

Когда появляется новое лицо, его «отпечаток» сравнивается со всеми ранее сохраненными. Сравнение происходит с определенным допуском (tolerance). Установил его равным 0.6 - это золотая середина, которая позволяет не путать разных людей, но и узнавать одного и того же человека при разном освещении или угле съемки.

3. Умный подсчет: один файл - один голос

Простая логика подсчета привела бы к абсурдным результатам: если курьер провел у двери 30 секунд, его лицо могло бы быть засчитано 50 раз в одном видео. Чтобы этого избежать, я ввел простое, но эффективное правило: считать каждое уникальное лицо только один раз за файл.

4. Создание красивых иконок

Чтобы в кадр попадала вся голова с прической и частью шеи, я добавил в функцию create_thumbnail логику с отступами. Она берет размер найденного лица и увеличивает область кадрирования на 50% по вертикали и горизонтали. Так превью в отчете выглядят гораздо лучше и живее.

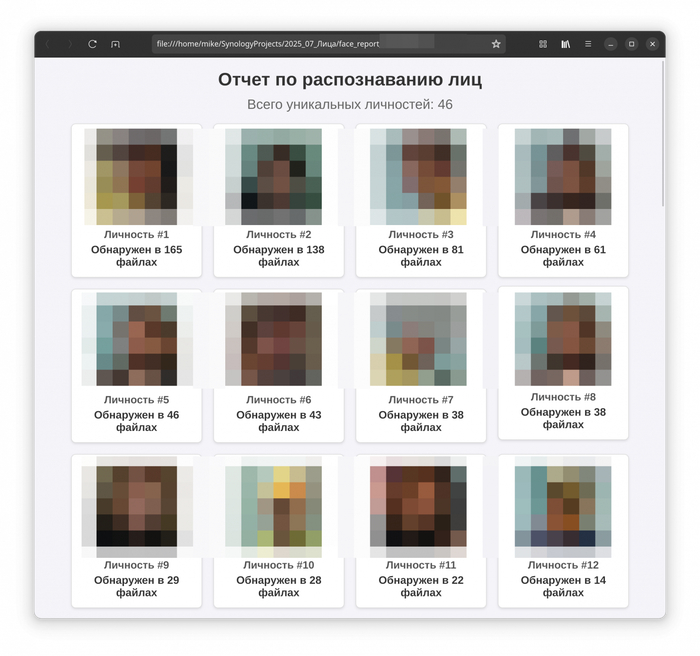

5. Генерация наглядного HTML-отчета

Финальный штрих - вся собранная информация (иконки, количество появлений) упаковывается в красивый и понятный HTML-отчет. Никаких сложных фреймворков: с помощью f-string и небольшого блока CSS генерируется страница, на которой все уникальные личности в этом эксперименте отсортированы по частоте появлений.

Часть 4: результаты и выводы

Для эксперимента я посчитал уникальных людей в выборке. Скрипт я запускал разово, отдельно для каждой камеры - это не постоянно работающий сервис, а скорее любопытная исследовательская игрушка.

Результаты оказались наглядными, но и показали пределы технологии. Качество распознавания напрямую зависит от исходного видео: камера домофона с узким углом и посредственным сенсором даёт мыльную картинку, на которой детали лица часто теряются. Для сравнения, камера 2,8 мм 4 Мп в лифтовом холле (широкоугольный объектив и матрица с разрешением 2560×1440) выдаёт значительно более чёткие кадры - глаза, контуры лица и текстура кожи читаются лучше, а значит, алгоритм реже ошибается.

Но и здесь есть нюанс: один и тот же человек в куртке и без неё, в кепке или с распущенными волосами, зачастую определяется как разные личности - видимо надо где-то крутить настройки. Поэтому цифры в отчёте стоит воспринимать не как абсолютную истину, а как любопытную статистику, показывающую общее движение людей, а не точный учёт.

Заключение

От простой идеи - «разово прогнать архив записей через алгоритмы компьютерного зрения и посмотреть, как быстро GPU справится с такой задачей» - я прошёл путь через череду технических ловушек: несовместимые версии Python, упёртый dlib, капризы CUDA и GCC.

К тому же это не сервис, а исследовательская проверка возможностей GPU.

Автор: Михаил Шардин

🔗 Моя онлайн-визитка

📢 Telegram «Умный Дом Инвестора»

19 августа 2025

Суд признал камеры с распознаванием лиц в метро законными — согласия граждан не нужно

Системы видеонаблюдения с функцией распознавания лиц давно стали обыденностью в метро — и даже на некоторых улицах. Но законна ли их работа, особенно если человека задерживают повторно — уже без нового нарушения? Один такой случай дошел до суда.

Прежде чем начать, приглашаю вас в мой ТГ-канал, где я ежедневно пишу о новинках законодательства, интересных делах, государстве, политике, экономике. Каждый вечер — дайджест важных новостей государственной и правовой сферы.

Что случилось?

Несколько лет назад в московском метро (и в некоторых других общественных местах) начали внедрять «умные» камеры, которые с помощью распознавания лиц помогают находить нарушителей общественного порядка.

Общественники тогда били тревогу — что это не что иное, как незаконный сбор персональных данных, нарушение закона о ПД и очередной шаг в сторону «цифрового концлагеря».

Тем не менее, камеры с распознаванием лиц заработали — и довольно скоро стали приносить плоды.

В июне 2023 года некий гражданин Б. позволил себе нанести на схему метрополитена одной из станций надпись, дискредитирующую Вооруженные силы. Со станции он успел уйти, но позже его все равно вычислили — с помощью той самой системы распознавания лиц.

В итоге Б. был оштрафован по ст. 20.3.3 КоАП РФ — против чего он, к слову, особенно и не возражал.

Однако уже через месяц, несмотря на то что штраф он оплатил, Б. снова задержали в метро и доставили в отдел полиции. Полицейские пояснили: система ГАИС «Сфера» выдала сигнал, что Б. — правонарушитель. Хотя на этот раз он ничего не нарушал. В итоге в отделении у него просто взяли отпечатки пальцев и отпустили.

Но Б. остался недоволен этой ситуацией. Он подал иск к Департаменту транспорта Москвы и УВД по метрополитену ГУ МВД России. В иске он требовал признать незаконным сбор и обработку его биометрических персональных данных, а также обязать удалить его данные из системы «Сфера».

Что решили суды?

Суд с возмущением Б. не согласился.

Во-первых, метро — это объект, на котором государство обязано обеспечивать транспортную безопасность. Согласно Постановлению Правительства от 08.10.2020 N 1641, на таких объектах допускается применение систем видеоидентификации, видеораспознавания, видеообнаружения и видеомониторинга — включая передачу и хранение данных в электронном виде.

В рамках работы таких систем действительно могут собираться биометрические персональные данные — сведения о физиологических и биологических особенностях человека, позволяющие установить его личность (в том числе изображение лица).

Закон о персональных данных (ФЗ N 152) разрешает сбор и обработку биометрии без согласия гражданина лишь в исключительных случаях — и обеспечение безопасности, включая транспортную, входит в число таких исключений (ст. 11 закона).

Кроме того, разъяснение по этому вопросу дал и Верховный суд. В п.п. 44–45 Постановления Пленума ВС РФ от 23.06.2015 N 25 указано: не требуется согласие на использование изображения гражданина, если это делается в целях защиты правопорядка и государственной безопасности.

В итоге суд признал действия полиции законными и отказал в иске. Апелляция и кассация оставили решение без изменений (Определение Московского городского суда по делу N 33а-0710/2025).

**********

Приглашаю вас в мой ТГ-канал, где я ежедневно пишу о новинках законодательства, интересных делах, государстве, политике, экономике. Каждый вечер — дайджест важных новостей государственной и правовой сферы.

**********

А если бы бабушка была дедушкой...?

Новость:

Алгоритм по распознаванию лиц, созданный компанией NtechLab, способен идентифицировать человека по фотографии 60-летней давности, рассказал генеральный директор компании NtechLab по разработке решений для видеоаналитики на основе искусственного интеллекта Алексей Паламарчук.

Человеческий глаз не может достоверно сказать, что вот этот 10-летний мальчик похож на вот этого 70-летнего дедушку, а искусственный интеллект может. Система может одновременно работать с сотней тысяч изображений,

— рассказал специалист.

Перестал работать Findclone

Есть ли здесь те, кто пользуется сервисом Findclone.ru? Сегодня вдруг перестал работать. Сам сайт открывается, оплата проходит, история поисков нормально работает. Но при попытке нового поиска просто виснет и всё. Пару дней назад ещё всё отлично работало. Непонятно, проблема у меня или у сервиса.

Есть ли вменяемые аналоги?

Автоматизация табеля

Эта система ещё глупая

Новые уже распознают подделку

взято с двача

Технологии: "Распознавание лиц"

Пару десятилетий назад систему распознавания лиц можно было увидеть разве что в шпионских боевиках. Сегодня это практически неотъемлемая часть смартфона и даже инфраструктуры крупных городов. Что это за технология, как она работает и где применяется?

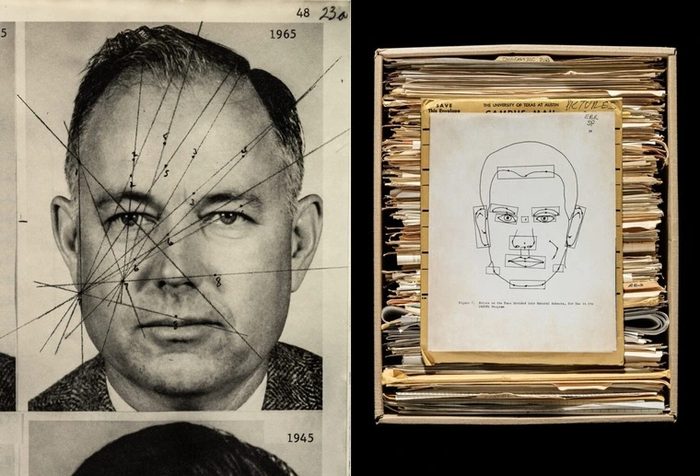

Как зародились системы распознавания лиц

Первые исследования по идентификации лиц проводились еще в 1960 году. Вуди Бледсо, профессор Техасского университета, основал свою небольшую компанию Panoramic Research Incorporated, где тестировал всевозможные алгоритмы, в том числе по распознаванию символов, вместе с коллегами. Несмотря на то, что особых успехов компания не снискала, согласно неподтвержденным источником оставаться на плаву ей позволяло ЦРУ.

Вуди Бледсо мечтал создать «интеллектуальную машину», в возможности которой входило распознавание лиц. В 1963 году он представил проект, согласно которому его система должна была идентифицировать по фотографиям десять лиц. Сегодня это выглядит ничтожно, но в те годы вычислительная техника представляла собой массивные шкафы с магнитными лентами и перфокартами. Не существовало даже универсального метода для элементарной оцифровки фотографий.

Спустя четыре года проб и ошибок было решено распознавать лицо на основе нескольких ключевых точек: нос, губы, ширина рта и так далее. Созданная система в итоге смогла идентифицировать лица, опираясь на вводимые данные и предлагая правильный вариант фотографии. Однако оставалась проблема с улыбкой, разными ракурсами и возрастами для одного того же человека. Из-за таких изменений алгоритм мог идентифицировать одного и того же человека на фотографиях как разных людей.

В итоге к 1967 году была спроектирована более совершенная система, которая уже успешно идентифицировала лица на основе обычных вырезок из газет. Что самое важное, была доказана высокая эффективность. Человек справлялся с сопоставлением подгруппы из 100 человек за три часа. Машина — за три минуты, пусть и с некоторыми огрехами.

В 1973 году удалось создать автоматизированную систему, которая из цифровых фотографий была способна самостоятельно извлекать данные о чертах лица. Ранее эти параметры приходилось вводить вручную. Несмотря на все эти достижения, практическое применение системы распознавания лиц началось лишь с 2010-х годов.

Причин несколько:

Рост вычислительной мощности. Только в последние годы производительность компьютерной техники стала достаточной, чтобы обрабатывать такие большие объемы данных.

Сформированная база. Десятилетия назад у корпораций и государственных органов не было фотографий не то что обычных граждан, но и многих преступников. Сегодня эта проблема решена благодаря социальным сетям и цифровой базе документов.

Развитие камер. Лишь в последние годы появились относительно недорогие камеры с достаточным качеством съемки, что позволило применять их массово как в смартфонах, так и в системах наблюдения.

Как работает система распознавания лиц

Распознавание лица — многоэтапный процесс. В первую очередь задействуются системы считывания, именно они получают снимок лица человека и передают его в центр обработки данных.

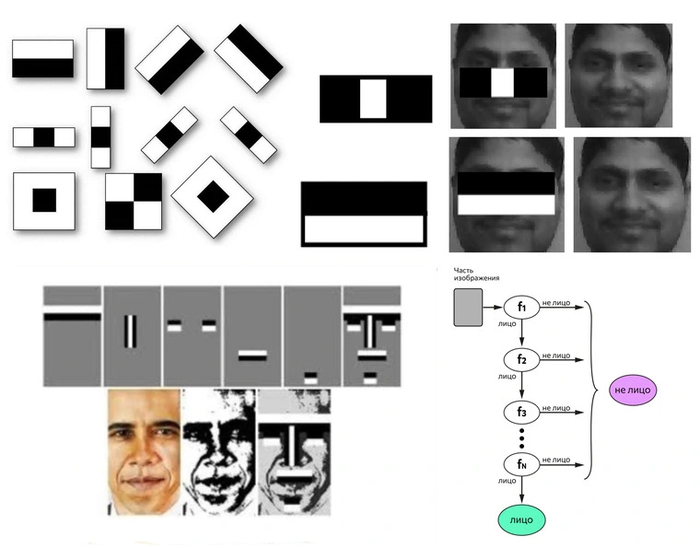

Обнаружение — первый этап. В кадр камер обычно попадает не только лицо, но и множество других объектов окружения. Человек сразу же способен определить, где автомобиль, где задний план, а где находится и сам человек. Но для компьютера любая фотография — это всего лишь набор пикселей. Решением этой проблемы стал метод Виолы — Джонса, разработанный в 2001 году.

Он основан на использовании специальных паттернов (масок), чтобы определять светлые и темные зоны. По специальной формуле из темных и светлых пикселей выполняются вычисления, на основании которых выносится результат, соответствует ли маска обрабатываемому участку изображения. В человеческом лице можно выделить конкретные паттерны. Как только алгоритм находит определенное число совпадений, он выносит вердикт — вот в этой зоне расположено человеческое лицо. Предварительно алгоритм обучают на других лицах.

Однако в последние несколько лет все больше систем уже используют нейросети. Они точнее, менее чувствительны к ракурсу съемки, а при достаточном аппаратном обеспечении еще и быстрее.

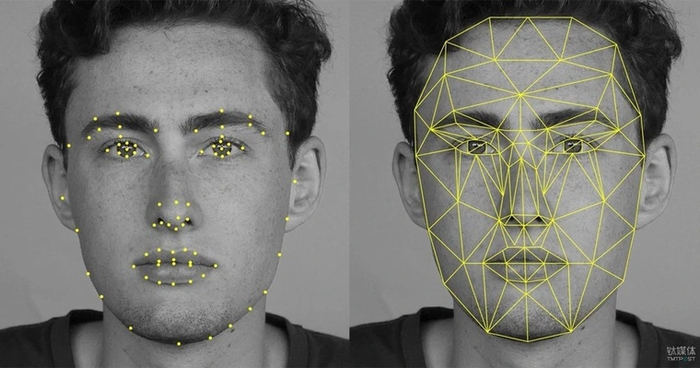

Нормализация — второй этап после обнаружения лица. Чтобы в дальнейшем было проще определять ключевые параметры, система пытается выстроить «идеальный кадр» — лицо, которое смотрит строго прямо. Здесь могут выполняться различные преобразования вроде поворота, изменения масштаба и других деформаций.

Построение «отпечатка лица» — следующий шаг. Как именно оно выполняется — зависит от используемого алгоритма. Все разнообразие методов можно разделить на две большие группы: геометрические и машинные.

Геометрические методы анализируют отличительные признаки изображений лица и формируют определенный массив данных на их основе. Массив сравнивается с эталоном и, если совпадение выше определенного порога — лицо найдено.

Для анализа обычно используются ключевые точки, между которыми вычисляются расстояния. Количество требуемых точек также зависит от каждого конкретного алгоритма — может использоваться от 68 до 2000 маркеров.

К геометрическим алгоритмам относится метод гибкого сравнения на графах, скрытые Марковские модели, метод главных компонент и другие.

Машинные методы — это нейросети. Они обучаются на огромной базе изображений и, анализируя совокупность определенных признаков, в итоге определяют совпадения лиц. Если максимально упростить, то для каждого фото формируется определенный вектор. Например, для трех фото (Анджелины Джоли и два Бреда Питта) мы получим три разных вектора. Разница между фотографиями Питта будет минимальной, что позволяет сделать вывод — на фото один и тот же человек.

У крупнейших компаний имеются авторские алгоритмы, которые постепенно модифицируются. Например, в 2018 году в тестировании NIST были представлены больше десяти алгоритмов от ведущих компаний в сфере распознавания лиц. Первое место заняла китайская компания Megvii, второе — российская VisionLabs, а замкнула тройку французская фирма OT-Morpho. К другим известным проектам также стоит отнести систему DeepFace (Meta**), FaceNet (Google) и Amazon Rekognition.

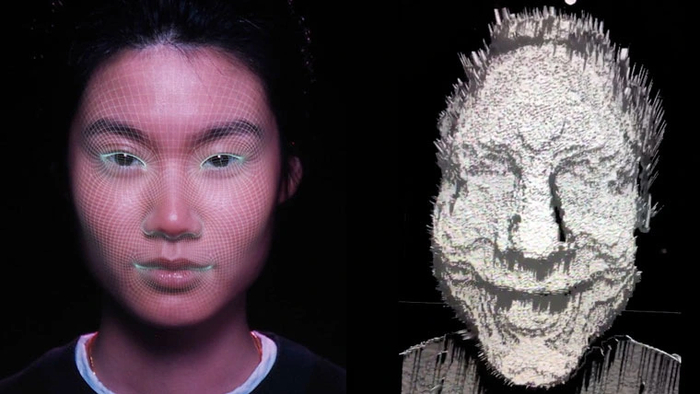

Помимо 2D-распознования лиц с коэффициентом ошибок в 0,1% существует технология 3D-распознования. Для нее коэффициент составляет всего 0,0005%. В таких системах используются лазерные сканеры с оценкой дальности или сканеры со структурированной подсветкой поверхности. Самая известная технология — FaceID от компании Apple, однако и у топовых Android-смартфонов также имеются системы распознавания с построением 3D-карты.

Применение систем распознавания лиц

Технология распознавания лиц используется в самых разнообразных сферах, как правило, в той или иной мере связанных с обеспечением безопасности.

Первая и одна из самых больших областей — городские системы видеонаблюдения. Практически во всех крупных развитых странах уже используется или одобрена биометрическая идентификация. Городские камеры в режиме реального времени распознают сотни тысяч лиц, сравнивая результаты с огромными базами данных. Это позволяет оперативно разыскивать преступников и нелегальных мигрантов. Аналогичные системы стоят практически во всех аэропортах, а также многих вокзалах.

Например, в 2018 году во время чемпионата мира по футболу в городах России камеры видеонаблюдения были подключены к системе Find Face Security, благодаря чему удалось выявить и задержать более 150 преступников. Система работает больше чем на десяти стадионах страны. В Китае алгоритмы получают данные со 170 миллионов камер. Если преступник попадется на одну из них, то, например, в Пекине его арестуют уже через семь минут!

Однако число камер — не абсолютный показатель. Например, площадь Пекина составляет 16 410 км², а это около 70 камер на квадратный километр . Площадь Парижа — всего 105 км², здесь плотность камер намного выше — 255 штук на квадратный километр! При этом следует учитывать и места расположения — многие проулки все равно останутся в «слепой зоне».

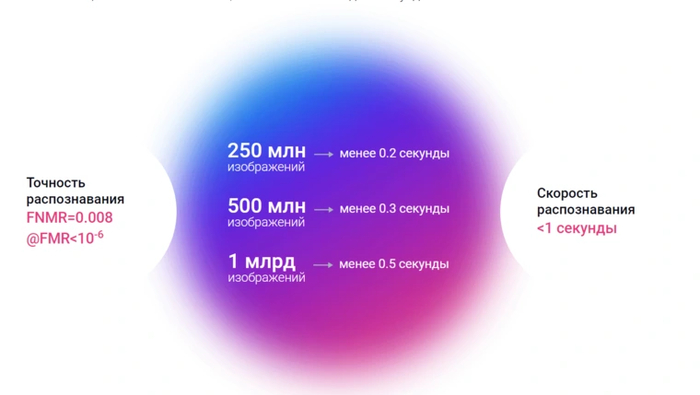

Одной из самых современных является система распознавания лиц в Москве. Используемые алгоритмы способны обрабатывать около одного миллиарда изображений всего за 0,5 секунды. При этом используется одновременно сразу четыре разных алгоритма распознавания от компаний NtechLab, TevianFaceSDK, VisionLabsLuna Platform и Kipod.

С 2018 года в России также начала работать ЕБС — единая биометрическая система, которая собирает «отпечатки» лиц и голоса пользователей. Благодаря этой разработке появилась возможность оформить какие-либо услуги в банках и других финансовых организациях без непосредственного посещения.

Второе по важности применение систем распознавания лиц — коммерческое. Сюда можно отнести:

Банковские услуги. Распознавание лиц позволяет не только идентифицировать мошенников и людей из черного списка, но и упрощает получение услуг. Например, в России уже проводились пилотные проекты по использованию банкоматов с идентификацией по лицу.

Системы контроля доступа. Обеспечить безопасность предприятия и даже офиса намного проще с развитой системой видеонаблюдения и распознаванием лиц. Это не только упрощает доступ, но и позволяет оперативно выявлять любых людей, которые несанкционированно проникли на территорию.

Сфера торговли. Интеллектуальные системы в магазинах могут предлагать вам, например, одежду подходящего размера, распознав вас по лицу. И это не говоря про быструю оплату по лицу.

Медицина. Продвинутые алгоритмы будут способны выявить отдельные эмоции, например, приступы эпилепсии или инсульты.

Мобильная техника. Идентификация по лицу уже стала таким же популярным методом авторизации, как и отпечаток пальца.

Чем грозит технология

Конечно, в теории быстрое обнаружение опасных преступников всего по паре снимков лица — отличная перспектива. Вот только на практике этика применения технологии нередко может выходить за рамки.

Например, у ФБР есть достаточно большая база под названием Next Generation Identification (NGI) — к 2014 году в ней было уже около 100 миллионов фотографий. Вот только оказалось, что в базе содержатся не только фото преступников, но и людей, которые никогда не привлекались. Более того, используемые алгоритмы гарантировали точность всего в 80-85%. Можно не только забыть про анонимность в глобальном масштабе — ошибки системы вполне могут превратить вас в преступника, если вы на него похожи или просто попали неудачно в кадр камеры.

Другая проблема — усиленная слежка со стороны корпораций. У многих из них и так уже имеется исчерпывающий цифровой портрет, включая ваши фотографии, геолокации и отпечатки пальцев. Однако благодаря данным систем распознавания лиц такие корпорации смогут отслеживать ваши передвижения буквально по минутам. Получается, даже если вы никогда и нигде не выкладывали свои фотографии в социальных сетях и даже на смартфоне, ваше лицо все равно может попасть в чьи-то базы данных.

Немаловажен и тот факт, что по лицу вас могут найти не только государственные органы, но и в принципе любой человек. После же недоброжелателям не составит труда отыскать и другие данные — адрес, телефон и так далее. Все это может вылиться в различные виды мошенничества, угроз и не только.

Во многих странах уже подаются иски на корпорации и государственные структуры, но в крупных городах работа систем распознавания лиц будет неизбежной. Остается только надеяться, что их использование будет максимально правомерным. Впрочем, защититься все еще можно. Алгоритмы несовершенные, поэтому кепка, маска и даже очки могут внести существенные погрешности, из-за которых будет проблематично считать ваш «отпечаток лица»

Вот как бывает

Китаянку заставили смыть макияж, после того как сканер в аэропорту не распознал её лицо

Жительница Шанхая не смогла пройти проверку системы распознавания лиц в аэропорту, поскольку её внешность не совпала с фотографией в паспорте. В итоге женщине пришлось прямо на месте делать демакияж.

Взято отсюда https://t.me/+wZUp8S3EIW80MTgy