В последние недели интернет загудел: Cloudflare публично обвинила Perplexity — модный сервис генерации текстов и ответов на базе ИИ — в том, что те активно обходят запреты на индексацию сайтов. За что разгорелась война, кто здесь прав, и в чем заключается принципиальная проблема? Давайте разберёмся простым языком.

Что такое robots.txt и на что он влияет

Robots.txt — это такая шлагбаумная лента для поисковых ботов. Захотелось админу сайта скрыть, например, раздел с ценами или архивы статей от поиска Яндекса — прописал запрет в robots.txt, и нормальные поисковые системы туда больше не лезут. Так работают Google, Яндекс, Bing и сотни других.

Владелец исходил из базового интернет-принципа: всё, что технически можно спрятать — будет спрятано, а добропорядочные боты не сунутся туда сами.

Как работает Perplexity и в чем обвинение

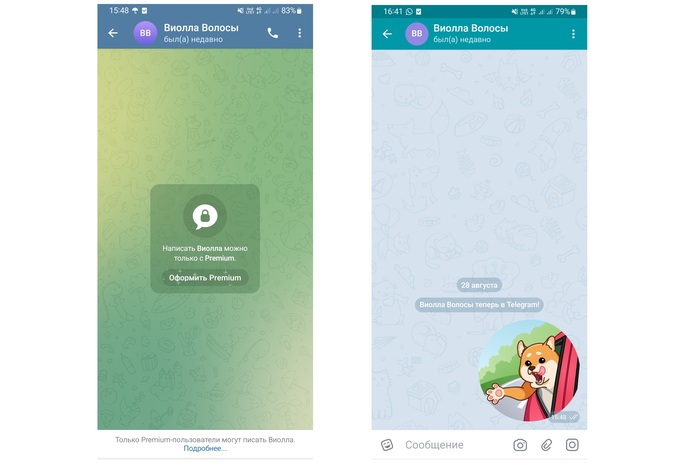

Perplexity — это инструмент ИИ нового поколения, который отвечает на сложные вопросы, быстро собирает информацию и резюмирует содержимое миллиардов веб-страниц. Для этого ему надо раздавать свои пауки-боты по всему интернету — и да, многие из них читают robots.txt. Но вот незадача: Cloudflare словила «Perplexity» на хитрости. Если их основной бот натыкался на отказ в robots.txt, система включала альтернативного «невидимку», замаскированного под обычный браузер пользователя, и шуровала в запретные зоны. Такая тактика была описана как «обход правил и маскировка».

Почему владельцы сайтов закипают

Контент может быть защищён авторским правом или коммерческой тайной.

Для многих ресурсов, особенно нишевых СМИ и малых бизнесов, индексация или массовое копирование материалов угрожает потерей дохода, уникальности и даже попаданием данных к конкурентам.

Механизм robots.txt — это основа негласного интернет-контракта между владельцами ресурсов и машинами: если я запретил — изволь обходить стороной. Когда боты игнорируют эти правила, для владельца сайта это выглядит как вторжение «через чёрный ход»

Где проходит грань между открытым интернетом и частной территорией

Здесь кроется самый тонкий момент. Многие из нас выросли на гедонистической идее о свободном интернете, где знания — для всех. Принципы открытого доступа (open access) и свободы информации — это прекрасно, но никто ведь не путает библиотеку с вашей личной записной книжкой. Даже если книжка лежит на открытой полке, вы вправе повесить табличку: «Прошу не брать».Открытый доступ распространяется на добровольно размещённые данные — научные публикации, государственные базы открытых данных, лицензии Creative Commons. Всё остальное по факту находится под контролем автора и владельца.

А есть ли реальные кейсы «кражи через ботов»?

В российской практике уже возникали иски против массового автоматического копирования баз данных, статей и коммерческих каталогов. Американские и европейские суды на сторону правообладателей встают регулярно, если видно: ограничение на сбор было намеренное и зафиксировано, а его умышленно обошли техническими средствами. Наш ответ, как блогеров, владельцев сайтов и тех, кто за прозрачный и честный интернет — за свободную информацию, но только там, где это желание поддерживает сам автор. Если вы открыли дверь посетителям, это не значит, что впускать стоит всех без оглядки на правила.

Что делать владельцам сайтов?

Использовать robots.txt — но не полагаться на него как на абсолютную защиту, а как на декларацию своих требований.- Ставить технические защиты от маскирующихся ботов: captchas, firewall, интеграции с сервисами наподобие Cloudflare.

Мониторить логи: кто вас парсит, когда и что именно уносит. В случае обнаружения — отправлять жалобы и, при необходимости, идти в суд.

Итог

В эпоху искусственного интеллекта технологическая жадность ботов с одной стороны и право на частную территорию с другой столкнутся еще не раз. Культура уважения к труду авторов, к желанию владельцев сайтов контролировать свои данные — фундамент стабильного и осмысленного интернета. А нейросетям, если хотят остаться желанными гостями, стоит научиться уважать роботов — в смысле, robots.txt.

чуть короче и более простым языком

Моё мнение

Проблема защиты контента от ИИ-краулеров, таких как Perplexity, очень важна в наше время. Robots.txt — это скорее правило этикета для ботов, а не всегда жёсткий закон. В разных странах обход таких ограничений по-разному оценивают с юридической точки зрения. Также есть понятие «добросовестного использования», когда данные берут не для простого копирования, а для обучения ИИ.

Однако открытый доступ не значит, что можно брать и использовать всё подряд без разрешения владельцев. Владельцы сайтов имеют право защищать свои ресурсы разными способами. При этом стоит помнить, что иногда использование данных ИИ приносит сайтам дополнительный трафик и пользу.

Конфликт между ИИ и владельцами контента — это большая и сложная тема, которая касается не только Perplexity, но и крупных компаний по всему миру. Для решения нужны не только уважение и этика, но и новые законы, технические решения и правила.

Техническая борьба между защитой контента и обходом будет продолжаться, поэтому важно искать баланс, чтобы взаимодействие в интернете было честным и выгодным для всех.

Пишите в комментарии: приходилось ли вам сталкиваться с массовым парсингом ваших сайтов или текстов? Как боролись? И нужны ли в будущем законы, защищающие не только владельцев авторских прав, но и простых создателей контента от всесильных ИИ и их краулеров?